Resumo:

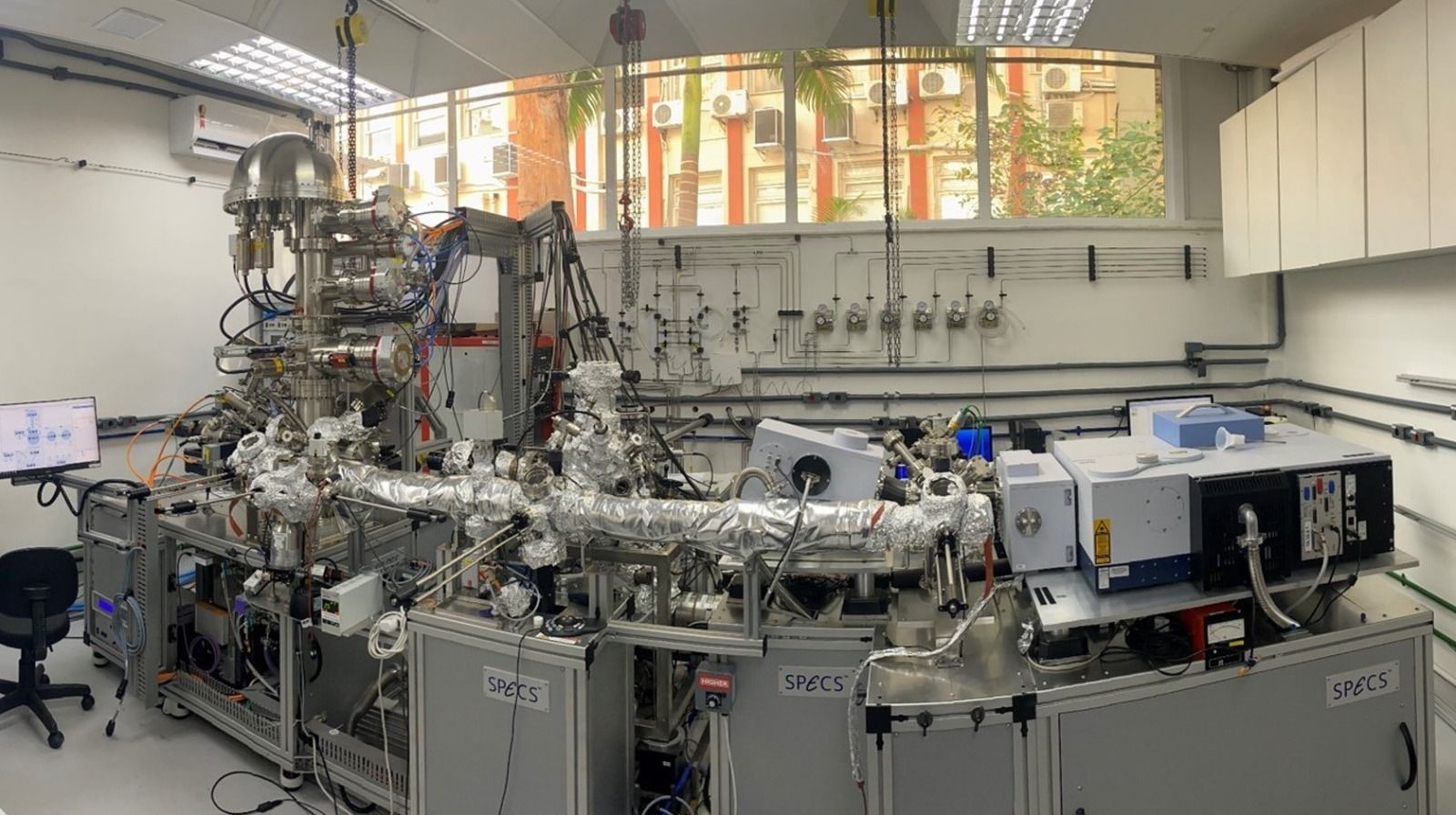

O estudo de superfícies constitui uma área multidisciplinar e de fronteira para ciência de materiais. Neste módulo, iremos abordar aspectos teóricos e experimentais envolvendo os fenômenos físicos e químicos que ocorrem em superfícies e interfaces. Esses fenômenos determinam os mecanismos de formação de interfaces sólido-líquidos na natureza, assim como são fundamentais para a a preparação e controle de tecnologia de crescimento de filmes finos e nanoestruturas. Alguns dos fenômenos que serão discutidos neste módulo são: reconstruções de superfície, crescimento de filmes finos, adsorção de moléculas e reatividade química. Além disso, vamos discutir técnicas de crescimento e caracterização de superfícies, como evaporação, difração de elétrons de baixa energia, espectroscopia de fotoelétrons e de reflexão-absorção de infravermelho.

Ementa

- Introdução a física da matéria condensada;

- Redes cristalinas:

- Cristalografia de superfícies;

- Difração de elétrons em baixa energia;

- Crescimento filmes finos;

- Tecnologia de vácuo;

- Espectroscopia de fotoelétrons excitados por raios-X (XPS):

- Níveis eletrônicos;

- Produção de raio-X/Instrumentação de XPS;

- Efeito fotoelétrico;

- Software de aquisição e tratamento de dados;

- espectroscopia de reflexão-absorção de infravermelho (FTIR/IRRAS):

- Modos de vibracionais;

- Absorção ótica/Espectroscopia ótica;

- Instrumentação de FTIR/IRRAS;

- Software de aquisição e tratamento de dados;

Pré-Requisitos:

Alunos da segunda metade do cursos de graduação em Física e Engenharia e alunos de pós-graduação com interesse no tema.Bibliografia:

- F. Bechstedt, /Principles of Surface Physics/, Springer-Verlag (2003).

- Milton Ohring, /Materials Science of Thin Films. Deposition and Structure/, Academic Press (2001).

- Hans Lüth, /Solid Surfaces, Interfaces and Thin Films/, Springer (2010).

- Gerhard Ertl, Jürgen Küppers: /Low Energy Electrons and Surface Chemistry/. Ed.2, Verlag Chemie (1985).

- Surface Science: Foundations of Catalysis and Nanoscience, 3rd ed., K. Kolasinski, Wiley 2012.